Материалы по тегу: dgx cloud

|

16.09.2025 [18:07], Владимир Мироненко

NVIDIA отказалась от активного развития собственного ИИ-облака DGX CloudNVIDIA отказалась от первоначальных планов относительно будущего облачной платформы DGX Cloud, запущенной в 2023 году в партнёрстве с ведущими облачными провайдерами, для которых оно было не очень-то и выгодно. Как сообщает Data Center Dynamics со ссылкой The Information, NVIDIA прекратила предлагать платформу новым клиентам из-за более высоких цен по сравнению с предложениями самих облачных провайдеров и теперь в основном использует её для нужд собственных исследовательских подразделений. Ранее NVIDIA планировала получить $150 млрд дохода от своего облачного бизнеса и даже собиралась арендовать ЦОД для поддержания его работы. Но в отчёте о финансовых результатах NVIDIA за II квартал 2026 финансового года больше нет упоминания DGX Cloud в расходах на облако, как это было в предыдущих кварталах. Вместе с тем в компании выразили несогласие с публикацией The Information по поводу того, что сервис не оправдал ожиданий. «DGX Cloud пользуется большим успехом как облако для собственных исследований и разработок NVIDIA в области ИИ, а также как своего рода “песочница”, в которой мы работаем с облачными партнёрами над оптимизацией их вычислительных стеков и с их разработчиками ИИ-стеков на основе CUDA», — сообщила Алексис Блэк Бьорлин (Alexis Black Bjorlin), руководитель DGX Cloud, изданию The Information. Она подчеркнула, что спрос в разрезе подразделений NVIDIA остаётся высоким, и компания продолжает расширять мощности DGX Cloud. Более того, у сервиса продолжают появляться новые клиенты. В частности, стартап SandboxAQ, работающий в области квантовых вычислений и ИИ, в который инвестировала NVIDIA, сообщил в апреле об использовании для своих разработок DGX Cloud. Ранее в этом году NVIDIA представила DGX Cloud Lepton — торговую площадку, предназначенную для использования разработчиками ускорителей от таких поставщиков, как CoreWeave, SoftBank и Yotta Data Services. Несмотря на то, что это решение открыло новые способы доступа к вычислительным мощностям, оно всё же вызвало конфликты с представителями инфраструктурного бизнеса, расценившими это как попытку NVIDIA найти пути общения с их клиентами напрямую, отметил ресурс Data Center Dynamics. Тем не менее, сервис DGX Cloud Lepton позволил более мелким поставщикам оставаться в экосистеме NVIDIA. Для разработчиков переход с DGX Cloud на Lepton означает более доступную вычислительную мощность по конкурентоспособным ценам в уже используемых ими облаках, а для NVIDIA — меньше конфликтов между каналами продаж и более строгий контроль над потоком рабочих нагрузок GPU по всему миру, отмечает Tom's Hardware.

21.05.2025 [10:39], Владимир Мироненко

GPU-маркетплейс NVIDIA DGX Cloud Lepton упростит доступ к дефицитным ИИ-ускорителямNVIDIA анонсировала GPU-маркетплейс NVIDIA DGX Cloud Lepton, которая позволит разработчикам со всего мира, создающим агентские и другие ИИ-приложения использовать NVIDIA Blackwell и другие модели ускорителей в глобальной сети партнёрских облаков (NCP): CoreWeave, Crusoe, Firmus, Foxconn, GMI Cloud, Lambda, Nebius, Nscale, Softbank и Yotta Data Services. Ожидается, что ведущие провайдеры облачных услуг и другие GPU-маркетплейсы также присоединятся к DGX Cloud Lepton. Разработчики смогут использовать вычислительные мощности ускорителй в определённых регионах как для вычислений по требованию, так и на постоянной основе. «NVIDIA DGX Cloud Lepton свяжет нашу сеть глобальных поставщиков облачных GPU с разработчиками в сфере ИИ, — заявил основатель и генеральный директор NVIDIA Дженсен Хуанг (Jensen Huang). — Вместе с нашими NCP мы строим ИИ-фабрику планетарного масштаба». По замыслу NVIDIA, платформа DGX Cloud Lepton поможет решить критическую задачу обеспечения разработчиков надёжными, высокопроизводительными ресурсами ускорителей путём унификации доступа к облачным ИИ-сервисам и мощностям собственных ускорителей. Платформа интегрирована с программным стеком NVIDIA, включая микросервисы NIM и NeMo, Blueprints и Cloud Functions. В числе основных преимуществ новой платформы компания назвала:

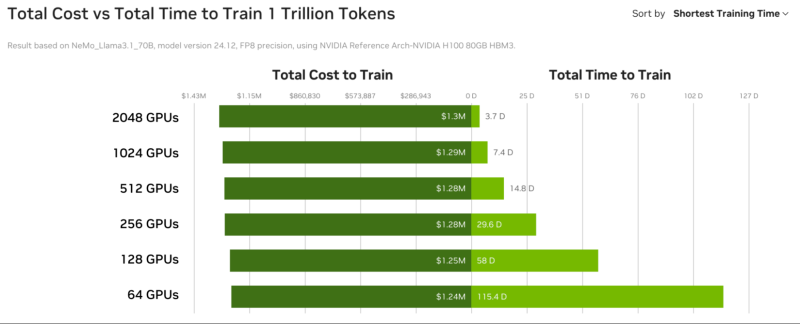

А для самих провайдеров, участвующих в DGX Cloud Lepton, предоставляется ПО для управления, которое обеспечивает диагностику состояния ускорителей в реальном времени и автоматизирует анализ первопричин возникших проблем, избавляя от ручной диагностики и сокращая время простоев. NVIDIA также анонсировала инициативу Exemplar Clouds, предназначенную для стандартизации прозрачного сравнительного анализа облачной ИИ-инфраструктуры. Это предложение должно решить серьёзную проблему, с которой сталкиваются разработчики и предприятия, развёртывающие рабочие ИИ-нагрузки — прогнозирование эффективности, надёжности и ценовой эффективности облачной платформы. Exemplar Clouds использует NVIDIA DGX Cloud Benchmarking, комплексный набор инструментов и рекомендаций для оптимизации производительности облачных ИИ-нагрузок и количественной оценки связи между стоимостью и производительностью.

24.03.2025 [20:02], Владимир Мироненко

ИИ в один клик: NVIDIA и Equinix предложат готовые к использованию кластеры DGX GB300 и DGX B300 в 45 регионах по всему мируЧтобы удовлетворить растущий спрос на ИИ-инфраструктуру, NVIDIA представила NVIDIA Instant AI Factory — управляемый сервис на базе платформ NVIDIA DGX SuperPOD с ускорителями Blackwell Ultra и ПО NVIDIA Mission Control. NVIDIA сообщила, что её партнёр Equinix станет первой компанией, которая предложит новые системы DGX GB300 и DGX B300 в своих предварительно сконфигурированных ЦОД с жидкостным или воздушным охлаждением, готовых к обработке ИИ-нагрузок и расположенных на 45 рынках по всему миру. Как пишет SiliconANGLE, Тони Пейкдей (Tony Paikeday), старший директор NVIDIA по маркетингу продуктов и систем ИИ, заявил, что партнёрство с Equinix позволит компании выйти на более чем 45 рынков по всему миру «с предварительно настроенными объектами, которые готовы в зависимости от спроса клиентов масштабировать, эксплуатировать и управлять ИИ-инфраструктурой». NVIDIA отметила, что сервис предоставит предприятиям полностью готовые ИИ-фабрики, оптимизированные для обучения современных моделей и рабочих нагрузок моделей рассуждений в реальном времени, что избавит от многомесячного планирования инфраструктуры перед развёртыванием. Поскольку Equinix предоставляет средства и инфраструктуру для разработки ИИ, Пейкдей возлагает большие надежды на платформу SuperPOD и считает, что она окажет позитивное влияние на развёртывание ИИ компаниями. «Equinix — ключевой компонент этой платформы, потому что вам нужно жидкостное охлаждение, вам нужны ЦОД следующего поколения, вам нужны сверхскоростные соединения с внешним миром, чтобы передавать эти данные», — заявил он.

18.07.2024 [18:23], Руслан Авдеев

Четвёртый за год: NVIDIA приобрела ещё один облачный стартап — Brev.devNVIDIA приобрела стартап, помогающий ИИ-разработчикам найти среди предложений облачных провайдеров наиболее подходящий по соотношению цена/качество доступ к ускорителям. Как сообщает портал CRN, это уже четвёртая заметная покупка NVIDIA с начала года. Представитель NVIDIA подтвердил, что сделка по приобретению Brev.dev действительно состоялась, но сумму и условия сделки не сообщил. Brev.dev предоставляет платформу для создания, обучения и внедрения ИИ-моделей в облаках. Целью Brev.dev, по словам самого стартапа, является поиск простейшего способа использования ускорителей для разработчиков систем ИИ и машинного обучения. Сотрудничество с NVIDIA обеспечит выполнение этой миссии, с комбинацией максимально возможно производительной аппаратной составляющей с самым передовым программным обеспечением. На сайте Brev.dev официальными партнёрами стартапа названы NVIDIA, Intel и AWS. Там же говорится, что платформа служит единым интерфейсом для взаимодействия AWS, Google Cloud Platform, Fluidstack и прочими облаками с ИИ-ускорителями. Это позволяет разработчикам искать подходящие инстансы на основе их цены и доступности. Хотя NVIDIA поставляет GPU и ИИ-ускорители облачным провайдерам более десяти лет, в последние годы компания уделяет немало внимания расширению собственного бизнеса в сфере облачных инфраструктур.

Источник изображения: NVIDIA В прошлом году компания запустила сервис DGX Cloud, который развёрнут в облачной инфраструктуре других провайдеров и на собственных мощностях и ИИ-суперкомпьютерах. Ранее в этом году NVIDIA купила ещё два стартапа для развития возможностей DGX Cloud. В конце апреля компания анонсировала покупку израильского стартапа Run:ai, занимающегося решениями для оркестрации ИИ-инфраструктур. Его планируется интегрировать в DGX Cloud, а также с DGX- и HGX-серверами. По имеющимся данным, покупка Run:ai обошлась в $700 млн. Практически одновременно с Run:ai компания приобрела ещё один израильский стартап — Deci, предлагающий ПО, способное на любом железе ускорить инференс ИИ-моделей, сохраняя точность данных. Сделку, по слухам, оценили приблизительно в $300 млн. Наконец, месяц назад NVIDIA купила калифорнийский стартап Shoreline.io, основанный бывшим управленцем AWS — компания разрабатывает ПО для автоматического устранения проблем в инфраструктуре ЦОД. По некоторым данным, команда Shoreline присоединилась к DGX Cloud, а покупка обошлась в $100 млн.

24.04.2024 [23:45], Владимир Мироненко

NVIDIA приобрела за $700 млн платформу оркестрации ИИ-нагрузок Run:aiКомпания NVIDIA объявила о приобретении стартапа Run:ai из Тель-Авива (Израиль), занимающегося разработкой ПО для управления рабочими нагрузками и оркестрации на базе Kubernetes, которое позволяет более эффективно использовать вычислительные ресурсы при работе с ИИ-приложениями. Стоимость сделки не раскрывается. По данным TechCrunch, покупка обошлась NVIDIA в $700 млн. Это одно из крупнейших приобретений Nvidia с момента покупки Mellanox за $6,9 млрд в марте 2019 года. Два года назад NVIDIA купила Bright Computing, разработчика решений для управления НРС-кластерами. NVIDIA отметила, что развёртывание ИИ-приложениЙ становится всё более сложным. Оркестрация генеративного ИИ, рекомендательных и поисковых систем, а также других рабочих нагрузок требует сложного планирования для оптимизации производительности. ПО Run:ai позволяет управлять и оптимизировать вычислительную инфраструктуру как локально, так и в облаке или в гибридных средах.

Источник изображения: NVIDIA Созданная стартапом открытая платформа поддерживает все популярные варианты Kubernetes и интегрируется со сторонними инструментами и платформами ИИ. Компании из различных отраслей используют платформу Run:ai для управления кластерами ускорителей в масштабе ЦОД. Как сообщается, на относительно раннем этапе деятельности Run:ai удалось создать большую клиентскую базу из компаний из списка Fortune 500, что позволило привлечь венчурные инвестиции. Перед сделкой Run:ai привлекла капитал в размере $118 млн от ряда инвесторов, включая Insight Partners, Tiger Global, S Capital и TLV Partners. NVIDIA заявила, что в ближайшем будущем продолжит предлагать продукты Run:ai в рамках той же бизнес-модели, а также продолжит инвестировать в развитие Run:ai в рамках платформы NVIDIA DGX Cloud, предоставляющей корпоративным клиентам доступ к вычислительной инфраструктуре и ПО для обучения моделей генеративного и других форм ИИ. Решения Run:ai уже интегрированы с NVIDIA DGX, NVIDIA DGX SuperPOD, NVIDIA Base Command, контейнерами NGC, ПО NVIDIA AI Enterprise и другими продуктами. По словам NVIDIA, пользователи серверов и рабочих станций NVIDIA DGX, а также DGX Cloud также получат доступ к возможностям Run:ai, что особенно полезно при развёртывании генеративного ИИ в нескольких ЦОД.

21.03.2024 [23:54], Владимир Мироненко

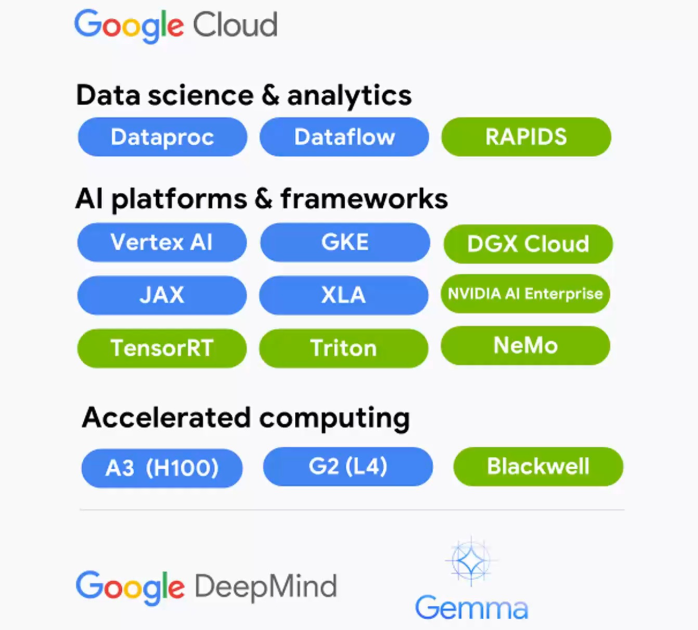

В Google Cloud появятся ускорители NVIDIA Grace BlackwellGoogle Cloud и NVIDIA объявили о расширении партнёрства, в рамках которого новая ИИ-платформа NVIDIA Grace Blackwell и NVIDIA DGX Cloud на её основе появятся в Google Cloud Platform, а клиентам станут доступны инференс-микросервисы NVIDIA NIM. Также было сказано об общедоступности DGX Cloud на базе NVIDIA H100.

Источник изображения: NVIDIA Среди ключевых нововведений отмечены следующие:

21.03.2024 [00:51], Владимир Мироненко

Облачный ИИ-суперкомпьютер AWS Project Ceiba получит 21 тыс. суперчипов NVIDIA GB200

aws

b100

dgx cloud

gb200

gtc 2024

hardware

nvidia

ии

инференс

информационная безопасность

облако

суперкомпьютер

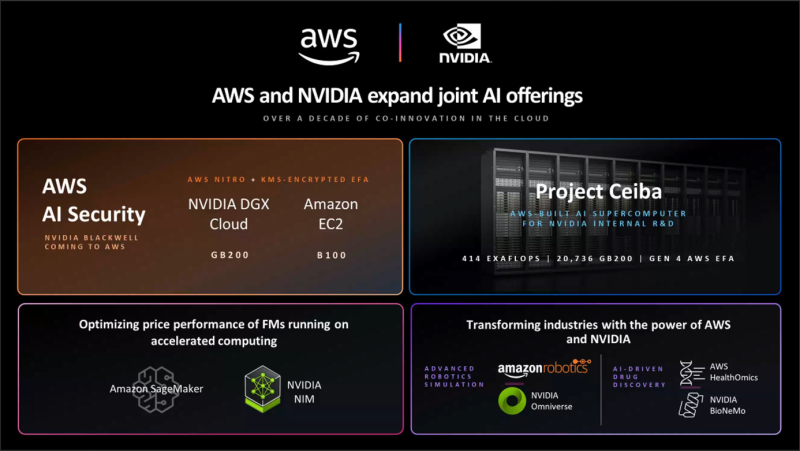

Amazon Web Services (AWS) и NVIDIA объявили о расширении сотрудничества, в рамках которого ускорители GB200 и B100 вскоре появятся в облаке AWS. Кроме того, компании объявили об интеграции Amazon SageMaker с NVIDIA NIM для предоставления клиентам более быстрого и дешёвого инференса, о появлении в AWS HealthOmics новых базовых моделей NVIDIA BioNeMo, а также о поддержке AWS обновлённой платформы NVIDIA AI Enterprise. Сотрудничество двух компаний позволило объединить в единую инфраструктуру их новейшие технологии, в том числе многоузловые системы на базе чипов NVIDIA Blackwell, ПО для ИИ, AWS Nitro, сервис управления ключами AWS Key Management Service (AWS KMS), сетевые адаптеры Elastic Fabric (EFA) и кластеры EC2 UltraCluster. Предложенная инфраструктура и инструменты позволят клиентам создавать и запускать LLM с несколькими триллионами параметров быстрее, в больших масштабах и с меньшими затратами, чем позволяли EC2-инстансы с ускорителями NVIDIA прошлого поколения. AWS предложит кластеры EC2 UltraClusters из суперускорителей GB200 NVL72, которые позволят объединить тысячи чипов GB200. GB200 будут доступны и в составе инстансов NVIDIA DGX Cloud. AWS также предложит EC2 UltraClusters с ускорителями B100. Amazon отмечает, что сочетание AWS Nitro и NVIDIA GB200 ещё больше повысит защиту ИИ-моделей: GB200 обеспечивает шифрование NVLink, EFA шифрует данные при передаче между узлами кластера, а KMS позволяет централизованно управлять ключами шифрования. Аппаратный гипервизор AWS Nitro, как и прежде, разгружает CPU узлов, беря на себя обработку IO-операций, а также защищает код и данные во время работы с ними. Эта возможность, доступная только в сервисах AWS, была проверена и подтверждена NCC Group. Инстансы с GB200 поддерживают анклавы AWS Nitro Enclaves, что позволяет напрямую взаимодействовать с ускорителем и данными в изолированной и защищённой среде, доступа к которой нет даже у сотрудников Amazon. Чипы Blackwell будут использоваться в обновлённом облачном суперкомпьютере AWS Project Ceiba, который будет использоваться NVIDIA для исследований и разработок в области LLM, генерация изображений/видео/3D, моделирования, цифровой биологии, робототехники, беспилотных авто, предсказания климата и т.д. Эта первая в своём роде машина на базе GB200 NVL72 будет состоять из 20 736 суперчипов GB200, причём каждый из них получит 800-Гбит/с EFA-подключение. Пиковая FP8-производительность системы составит 414 Эфлопс.

20.03.2024 [02:17], Владимир Мироненко

Oracle и NVIDIA предложат суверенные ИИ-фабрики

dgx cloud

gb200

gtc 2024

nvidia

oracle

oracle cloud infrastructure

software

ии

конфиденциальность

облако

частное облако

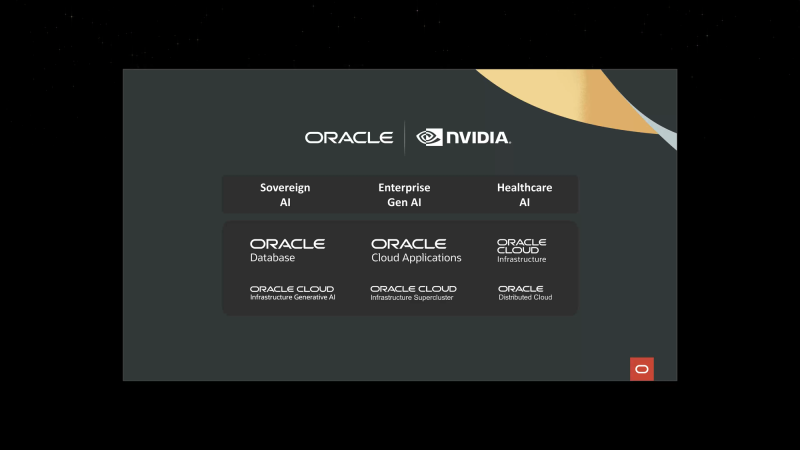

Oracle и NVIDIA объявили о расширении сотрудничества для предоставления суверенного ИИ клиентам по всему миру — программно-аппаратные решения обеих компаний позволят правительствам и предприятиями формировать ИИ-фабрики, говорится в пресс-релизе. Облачные сервисы Oracle используют ряд платформ NVIDIA, включая аппаратную инфраструктуру и программную платформу NVIDIA AI Enterprise, в том числе недавно анонсированные микросервисы вывода NVIDIA NIM. Такие ИИ-фабрики позволят развернуть облачные сервисы, работающие локально и размещённые в безопасных кампусах на территории страны или организации. Сочетание полнофункциональной ИИ-платформы NVIDIA с корпоративным ИИ-инструментами Oracle, которые можно развернуть в выделенном регионе OCI, позволит получить современное ИИ-решение с повышенным уровенем контроля, защиты и безопасности. По словам Oracle, компания является единственным гиперскейлером, способным предоставлять ИИ-решения и полноценные облачные услуги локально и в любом месте. Oracle также задействует чипы NVIDIA Blackwell (GB200 и B200) в OCI Supercluster и OCI Compute. OCI Supercluster станет значительно быстрее благодаря новым bare metal-инстансам, RDMA-сети со сверхмалой задержкой и высокопроизводительному хранилищу. В OCI появятся и сервисы NVIDIA NIM и CUDA-X, а также NVIDIA NeMo Retriever. Наконец, в DGX Cloud on OCI станут доступны инстансы на базе суперускорителей GB200 NVL72 для работы с LLM с триллионами параметров. Полный кластер DGX Cloud будет включать более 20 тыс. ускорителей GB200, интерконнект NVLink 5 и сеть NVIDIA InfiniBand XDR.

28.11.2023 [22:20], Игорь Осколков

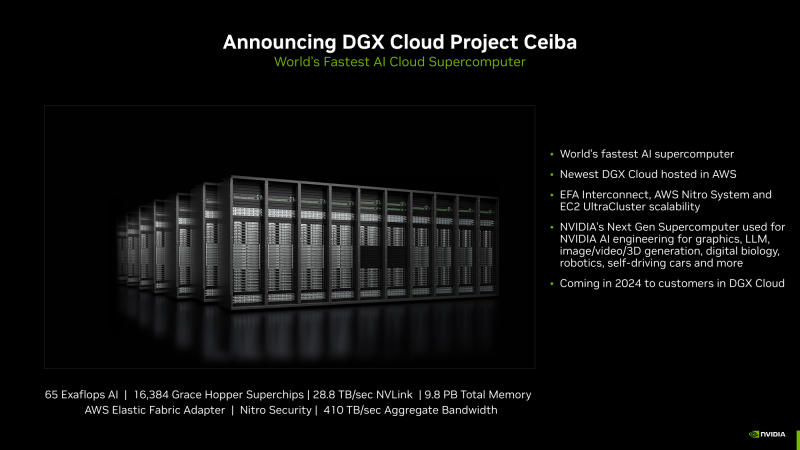

NVIDIA анонсировала суперускоритель GH200 NVL32 и очередной самый мощный в мире ИИ-суперкомпьютер Project CeibaAWS и NVIDIA анонсировали сразу несколько новых совместно разработанных решений для генеративного ИИ. Основным анонсом формально является появление ИИ-облака DGX Cloud в инфраструктуре AWS, вот только облако это отличается от немногочисленных представленных ранее платформ DGX Cloud тем, что оно первом получило гибридные суперчипах GH200 (Grace Hoppper), причём в необычной конфигурации.

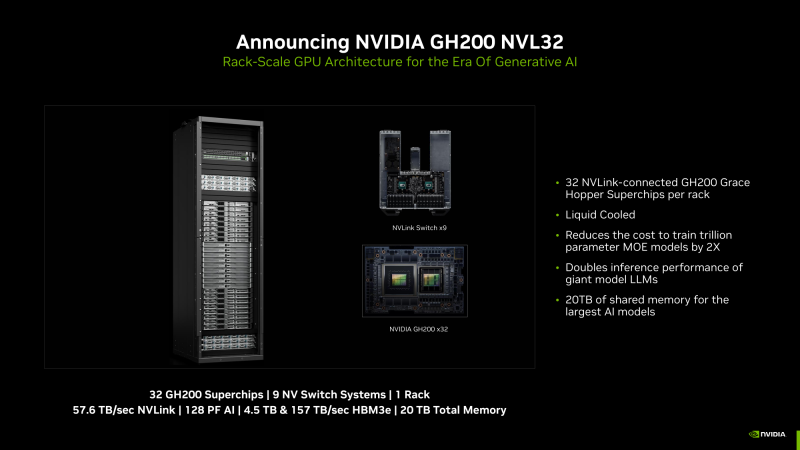

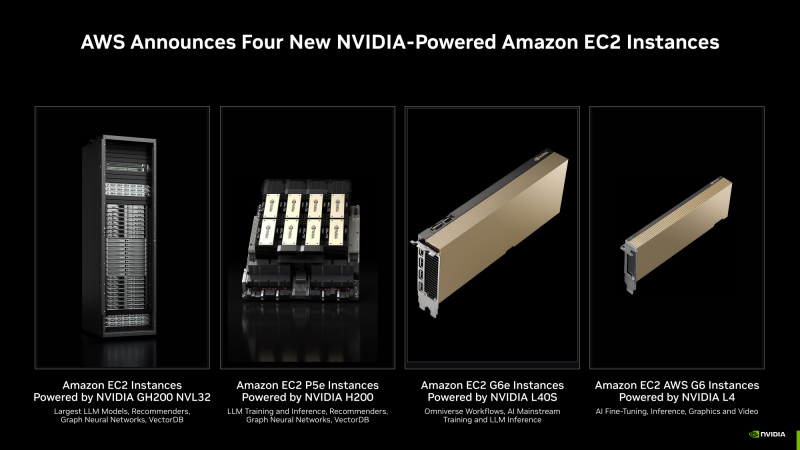

Изображения: NVIDIA В основе AWS DGX Cloud лежит платформа GH200 NVL32, но это уже не какой-нибудь сдвоенный акселератор вроде H100 NVL, а целая, готовая к развёртыванию стойка, включающая сразу 32 ускорителя GH200, провязанных 900-Гбайт/с интерконнектом NVLink. В состав такого суперускорителя входят 9 коммутаторов NVSwitch и 16 двухчиповых узлов с жидкостным охлаждением. По словам NVIDIA, GH200 NVL32 идеально подходит как для обучения, так и для инференса действительно больших LLM с 1 трлн параметров. Простым перемножением количества GH200 на характеристики каждого ускорителя получаются впечатляющие показатели: 128 Пфлопс (FP8), 20 Тбайт оперативной памяти, из которых 4,5 Тбайт приходится на HBM3e с суммарной ПСП 157 Тбайтс, и агрегированная скорость NVLink 57,6 Тбайт/с. И всё это с составе одного EC2-инстанса! Да, новая платформа использует фирменные DPU AWS Nitro и EFA-подключение (400 Гбит/с на каждый GH200). Новые инстансы, пока что безымянные, можно объединять в кластеры EC2 UltraClasters. Одним из таких кластеров станет Project Ceiba, очередной самый мощный в мире ИИ-суперкомпьютер с FP8-производительность 65 Эфлопс, объединяющий сразу 16 384 ускорителя GH200 и имеющий 9,1 Пбайт памяти, а также агрегированную пропускную способность интерконнекта на уровне 410 Тбайт/с (28,8 Тбайт/с NVLink). Он и станет частью облака AWS DGX Cloud, которое будет доступно в начале 2024 года. В скором времени появятся и EC2-инстансы попроще: P5e с NVIDIA H200, G6e с L40S и G6 с L4.

18.11.2023 [00:38], Владимир Мироненко

NVIDIA и Microsoft развернули в облаке Azure платформу для создания приложений генеративного ИИКомпания NVIDIA представила на конференции Microsoft Ignite 2023 сервис NVIDIA AI Foundry, который позволит предприятиям ускорить разработку и настройку пользовательских приложений генеративного ИИ с использованием собственных данных, развёртываемых в облаке Microsoft Azure. NVIDIA AI Foundry объединяет три элемента: набор базовых моделей NVIDIA AI Foundation, платформу и инструменты NVIDIA NeMo, а также суперкомпьютерные сервисы NVIDIA DGX Cloud AI. Вместе они предоставляют предприятиям комплексное решение для создания пользовательских моделей генеративного ИИ. Компании смогут затем развёртывать свои индивидуальные модели с помощью платформы NVIDIA AI Enterprise для создания приложений ИИ, включая интеллектуальный поиск, обобщение и генерацию контента. «Предприятиям нужны кастомные модели для реализации специализированных навыков, основанных на собственной ДНК их компании — их данных, — сообщил глава NVIDIA Дженсен Хуанг (Jensen Huang), — Сервис NVIDIA AI Foundry сочетает в себе наши технологии моделей генеративного ИИ, опыт обучения LLM и гигантскую фабрику ИИ. Мы создали это в Microsoft Azure, чтобы предприятия по всему миру могли подключить свою собственную модель к ведущим в мире облачным сервисам Microsoft».

Источник изображения: NVIDIA Сервис NVIDIA AI Foundry можно использовать для настройки моделей для приложений на базе генеративного ИИ в различных отраслях, включая корпоративное ПО, телекоммуникации и медиа. При их развёртывании компании смогут использовать метод генерации с расширенным поиском (RAG), чтобы привязать свои модели к базе корпоративных данных для получения актуальных ответов. В сервисе NVIDIA Foundry клиенты смогут выбирать из нескольких моделей NVIDIA AI Foundation, включая новое семейство Nemotron-3 8B в составе каталога моделей Azure AI. Разработчики также могут получить доступ к моделям Nemotron-3 8B в каталоге NVIDIA NGC и к популярным моделям Llama 2, Mistral и Stable Diffusion XL. NVIDIA сообщила, что одними из первых новым сервисом для создания моделей воспользовались SAP, Amdocs и Getty Images. Наконец, в Azure стала доступна и платформа NVIDIA DGX Cloud AI, в рамках которой клиенты смогут арендовать кластеры, состоящие из тысяч ускорителей NVIDIA и воспользоваться ПО NVIDIA AI Enterprise, включая NeMo, для ускорения настройки LLM. Клиенты Azure смогут использовать существующие кредиты Microsoft Azure Consumption Commitment для ускорения разработки ИИ-моделей. Отметим, что первым сервис DGX Cloud получило облако Oracle, где Microsoft арендует ускорители той же NVIDIA для собственных нужд. По слухам, компания также использует ускорители CoreWeave и Lambda Labs, а также разрабатывает более экономичные ИИ-модели. По-видимому, продавать доступ к аппаратным и иным решениям NVIDIA для Microsoft выгоднее, чем использовать для своих нужд. Впрочем, если всё сложится удачно, то компания перейдёт на ИИ-ускорители Maia 100 собственной разработки. |

|